M’usa, con l’apostrofo. Le donne di PicassoLetizia Bravi

- 0 Anmeldelser

- 0

- Episode

- 1917 of 2086

- Længde

- 5M

- Sprog

- Engelsk

- Format

- Kategori

- Fakta

Adversarial algorithms can systematically probe large language models like OpenAI’s GPT-4 for weaknesses that can make them misbehave. Read the story here.

Learn about your ad choices: dovetail.prx.org/ad-choices

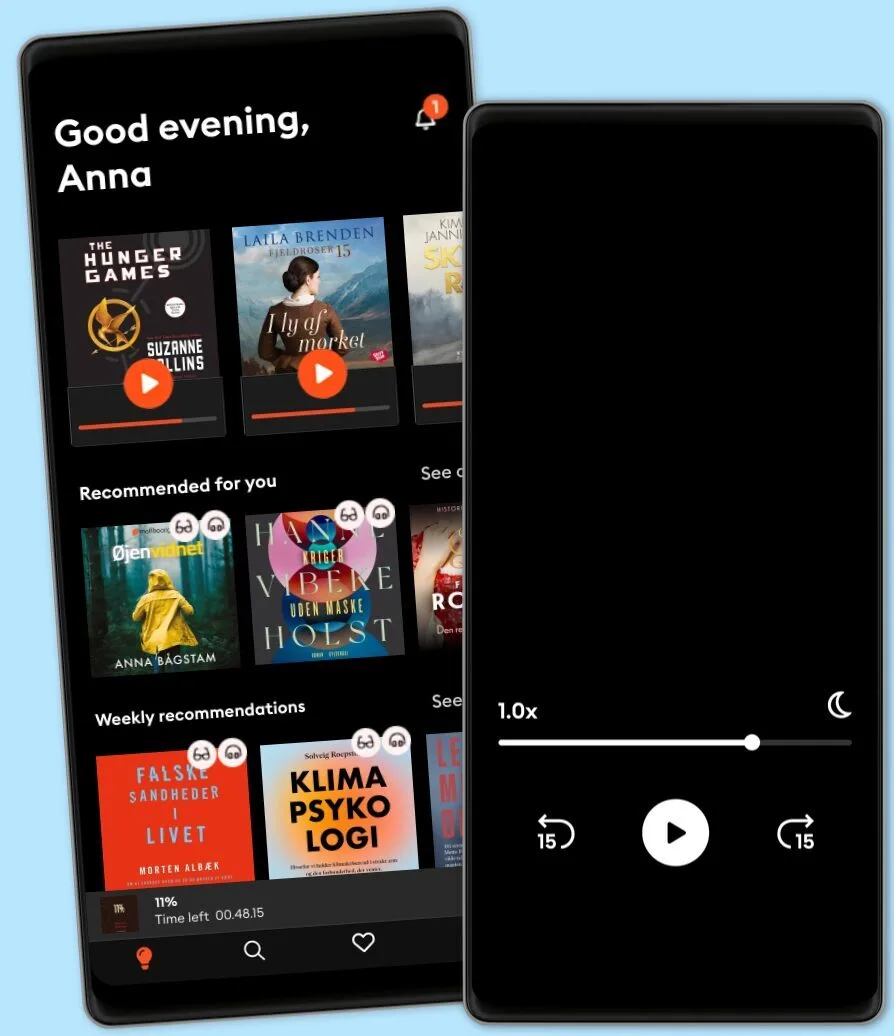

Lyt når som helst, hvor som helst

Nyd den ubegrænsede adgang til tusindvis af spændende e- og lydbøger - helt gratis

- Lyt og læs så meget du har lyst til

- Opdag et kæmpe bibliotek fyldt med fortællinger

- Eksklusive titler + Mofibo Originals

- Opsig når som helst

Other podcasts you might like ...

- FC PopCornFilm Companion

- The Big StoryThe Quint

- DiskoteksbrandenAntonio de la Cruz

- Dragon gateEdith Söderström

- En amerikansk epidemiPatrick Stanelius

- En värld i brand: Andra världskriget och sanningenAnton Vretander

- FamiljenFrida Anund

- Hagen-fallet: Spårlöst försvunnenAntonio de la Cruz

- HelikopterpilotenVictoria Rinkous

- M’usa, con l’apostrofo. Le donne di PicassoLetizia Bravi

- FC PopCornFilm Companion

- The Big StoryThe Quint

- DiskoteksbrandenAntonio de la Cruz

- Dragon gateEdith Söderström

- En amerikansk epidemiPatrick Stanelius

- En värld i brand: Andra världskriget och sanningenAnton Vretander

- FamiljenFrida Anund

- Hagen-fallet: Spårlöst försvunnenAntonio de la Cruz

- HelikopterpilotenVictoria Rinkous

Læs mere

Sprog og region

Dansk

Danmark