LeakPro skapar förutsättningar för samarbeten kring känslig data

- Episode

- 71

- Published

- 29. jan. 2025

- Forlag

- 0 Anmeldelser

- 0

- Episode

- 71 of 80

- Længde

- 37M

- Sprog

- Svensk

- Format

- Kategori

- Fakta

Johan Östman, forskare och projektledare på AI Sweden, berättar i det här avsnittet om projektet LeakPro. Ambitionen är att bättre förstå – och därmed också kunna förhålla sig till – risken för att modeller läcker träningsdata.

– Ska man i en mening beskriva vad vi försöker göra handlar det om att låsa upp samarbeten kring känslig data, säger han.

LeakPro bygger vidare på slutsatser som drogs i ett tidigare AI Sweden-projekt. I Regulatory Pilot Testbed jobbade Region Halland och Sahlgrenska Universitetssjukhuset tillsammans med IMY och AI Sweden. Syftet var då att utforska hur federerad inlärning skulle kunna användas i sjukvården. Integritetsskyddsmyndigheten konstaterade att det inte gick att bedöma sannolikheten för att modeller, tränade på personuppgifter, läcker träningsdata. Som en konsekvens måste modellerna i sig betraktas som personuppgifter, och därför hanteras utifrån hur personuppgifter regleras.

I LeakPro är ambitionen att svara på den centrala frågan: Hur stor är sannolikheten för att en viss modell läcker träningsdata? De som jobbar för att hitta svaret är AstraZeneca, Region Halland, Sahlgrenska Universitetssjukhuset, Scaleout, Syndata, RISE och AI Sweden.

Känner man till sannolikheten för läckage öppnas två dörrar. Den ena gör det möjligt att fatta verksamhetsbeslut. “Är risken för att träningsdata läcker rimlig i förhållande till värdet som modellen kan skapa?” Den andra gör det möjligt för utvecklare att utvärdera sina modeller och utveckla dem vidare så att risken för läckage minskar till en acceptabel nivå.

– Det vi vill bygga är något som är relevant och användbart, och för att göra det måste vi ligga i frontlinjen av den akademiska forskningen, för att använda de skarpaste attackerna som finns, säger Johan Östman.

I poddavsnittet utvecklar han bakgrunden till projektet, hur samverkan mellan aktörer från olika sektorer stärker LeakPro, vad målbilden är, och hur resan dit ser ut.

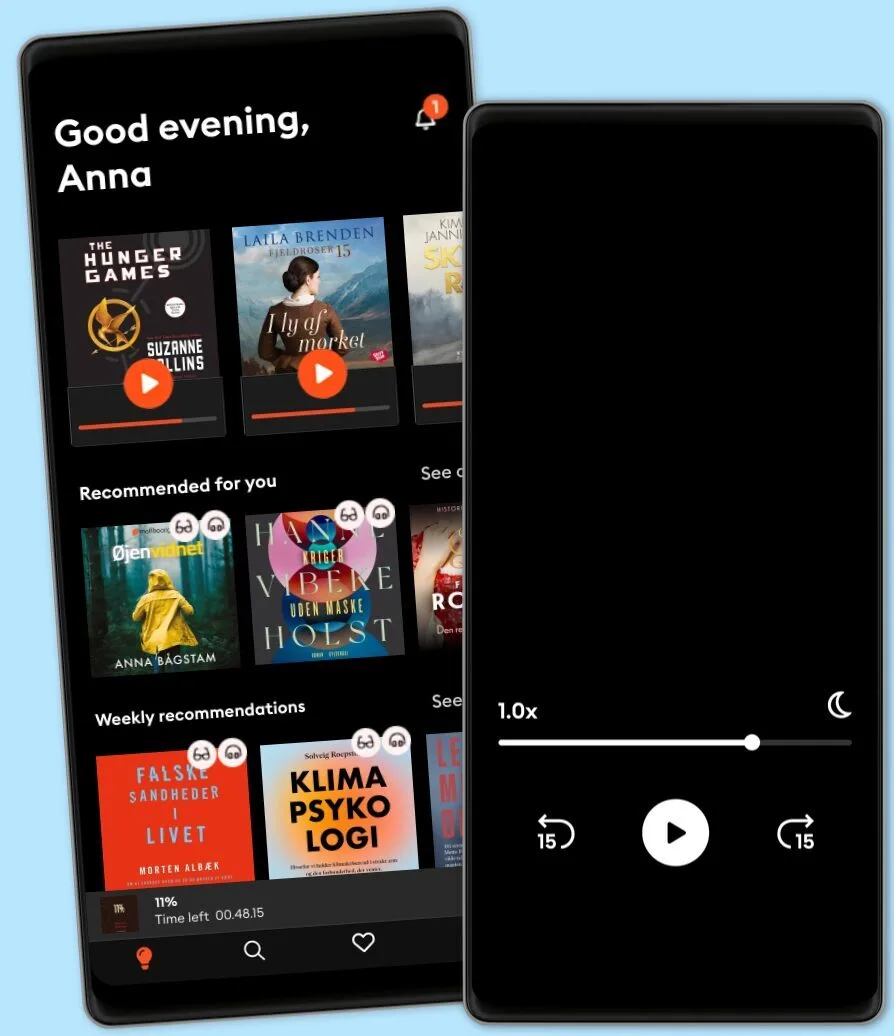

Lyt når som helst, hvor som helst

Nyd den ubegrænsede adgang til tusindvis af spændende e- og lydbøger - helt gratis

- Lyt og læs så meget du har lyst til

- Opdag et kæmpe bibliotek fyldt med fortællinger

- Eksklusive titler + Mofibo Originals

- Opsig når som helst

Other podcasts you might like ...

- The Book ReviewThe New York Times

- M’usa, con l’apostrofo. Le donne di PicassoLetizia Bravi

- FC PopCornFilm Companion

- DiskoteksbrandenAntonio de la Cruz

- Dragon gateEdith Söderström

- En amerikansk epidemiPatrick Stanelius

- En värld i brand: Andra världskriget och sanningenAnton Vretander

- FamiljenFrida Anund

- Försvunnen: Fallet ToveMaria Thulin

- Hagen-fallet: Spårlöst försvunnenAntonio de la Cruz

- The Book ReviewThe New York Times

- M’usa, con l’apostrofo. Le donne di PicassoLetizia Bravi

- FC PopCornFilm Companion

- DiskoteksbrandenAntonio de la Cruz

- Dragon gateEdith Söderström

- En amerikansk epidemiPatrick Stanelius

- En värld i brand: Andra världskriget och sanningenAnton Vretander

- FamiljenFrida Anund

- Försvunnen: Fallet ToveMaria Thulin

- Hagen-fallet: Spårlöst försvunnenAntonio de la Cruz

Dansk

Danmark